Rook pour gérer le système de fichiers

Rédigé par dada / 08 novembre 2018 / 4 commentaires

Installer Rook

Installer les dépendances

apt-get install ceph-fs-common ceph-common

Récupérer le binaire RBD

cd /bin

sudo curl -O https://raw.githubusercontent.com/ceph/ceph-docker/master/examples/kubernetes-coreos/rbd

sudo chmod +x /bin/rbd

rbd #Command to download ceph images

Ajouter le dépôt Rook dans Helm

dada@k8smaster:~$ helm repo add rook-beta https://charts.rook.io/beta

"rook-beta" has been added to your repositories

Récupérer Rook

dada@k8smaster:~$ helm install --namespace rook-ceph-system rook-beta/rook-ceph

NAME: torrid-dragonfly

LAST DEPLOYED: Sun Nov 4 11:22:24 2018

NAMESPACE: rook-ceph-system

STATUS: DEPLOYED

dada@k8smaster:~$ kubectl --namespace rook-ceph-system get pods -l "app=rook-ceph-operator"

NAME READY STATUS RESTARTS AGE

rook-ceph-operator-f4cd7f8d5-zt7f4 1/1 Running 0 2m25

dada@k8smaster:~$ kubectl get pods --all-namespaces -o wide | grep rook

rook-ceph-system rook-ceph-agent-pb62s 1/1 Running 0 4m10s 192.168.0.30 k8snode1 <none

rook-ceph-system rook-ceph-agent-vccpt 1/1 Running 0 4m10s 192.168.0.18 k8snode2 <none>

rook-ceph-system rook-ceph-operator-f4cd7f8d5-zt7f4 1/1 Running 0 4m24s 10.244.2.62 k8snode2 <none>

rook-ceph-system rook-discover-589mf 1/1 Running 0 4m10s 10.244.2.63 k8snode2 <none>

rook-ceph-system rook-discover-qhv9q 1/1 Running 0 4m10s 10.244.1.232 k8snode1 <none>

Création du cluster

#################################################################################

# This example first defines some necessary namespace and RBAC security objects.

# The actual Ceph Cluster CRD example can be found at the bottom of this example.

#################################################################################

apiVersion: v1

kind: Namespace

metadata:

name: rook-ceph

---

apiVersion: v1

kind: ServiceAccount

metadata:

name: rook-ceph-cluster

namespace: rook-ceph

---

kind: Role

apiVersion: rbac.authorization.k8s.io/v1beta1

metadata:

name: rook-ceph-cluster

namespace: rook-ceph

rules:

- apiGroups: [""]

resources: ["configmaps"]

verbs: [ "get", "list", "watch", "create", "update", "delete" ]

---

# Allow the operator to create resources in this cluster's namespace

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1beta1

metadata:

name: rook-ceph-cluster-mgmt

namespace: rook-ceph

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: rook-ceph-cluster-mgmt

subjects:

- kind: ServiceAccount

name: rook-ceph-system

namespace: rook-ceph-system

---

# Allow the pods in this namespace to work with configmaps

kind: RoleBinding

apiVersion: rbac.authorization.k8s.io/v1beta1

metadata:

name: rook-ceph-cluster

namespace: rook-ceph

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: Role

name: rook-ceph-cluster

subjects:

- kind: ServiceAccount

name: rook-ceph-cluster

namespace: rook-ceph

---

#################################################################################

# The Ceph Cluster CRD example

#################################################################################

apiVersion: ceph.rook.io/v1beta1

kind: Cluster

metadata:

name: rook-ceph

namespace: rook-ceph

spec:

cephVersion:

# For the latest ceph images, see https://hub.docker.com/r/ceph/ceph/tags

image: ceph/ceph:v13.2.2-20181023

dataDirHostPath: /var/lib/rook

dashboard:

enabled: true

storage:

useAllNodes: true

useAllDevices: false

config:

databaseSizeMB: "1024"

journalSizeMB: "1024"

kubectl create -f cluster.yaml

dada@k8smaster:~/rook$ kubectl get pods -n rook-ceph -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE

rook-ceph-mgr-a-5f6dd98574-tm9md 1/1 Running 0 3m3s 10.244.2.126 k8snode2 <none>

rook-ceph-mon0-sk798 1/1 Running 0 4m36s 10.244.1.42 k8snode1 <none>

rook-ceph-mon1-bxgjt 1/1 Running 0 4m16s 10.244.2.125 k8snode2 <none>

rook-ceph-mon2-snznb 1/1 Running 0 3m48s 10.244.1.43 k8snode1 <none>

rook-ceph-osd-id-0-54c856d49d-77hfr 1/1 Running 0 2m27s 10.244.1.45 k8snode1 <none>

rook-ceph-osd-id-1-7d98bf85b5-rt4jw 1/1 Running 0 2m26s 10.244.2.128 k8snode2 <none>

rook-ceph-osd-prepare-k8snode1-dzd5v 0/1 Completed 0 2m41s 10.244.1.44 k8snode1 <none>

rook-ceph-osd-prepare-k8snode2-2jgvg 0/1 Completed 0 2m41s 10.244.2.127 k8snode2 <none>

Créer le système de fichiers

apiVersion: ceph.rook.io/v1beta1

kind: Pool

metadata:

name: replicapool

namespace: rook-ceph

spec:

replicated:

size: 3

---

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: rook-ceph-block

provisioner: ceph.rook.io/bloc

parameters:

pool: replicapool

clusterNamespace: rook-ceph

kubectl create -f storageclass.yaml

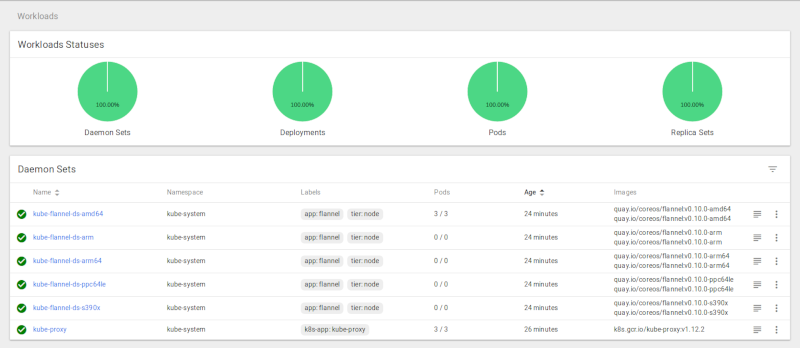

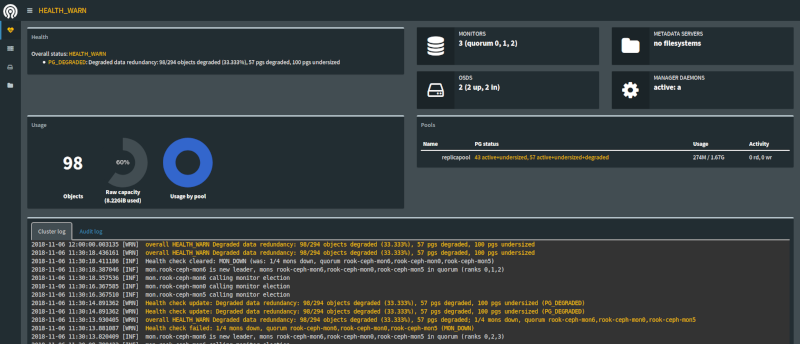

Le Dashboard Ceph

dada@k8smaster:~/rook$ cat dashboard-external.yaml

apiVersion: v1

kind: Service

metadata:

name: rook-ceph-mgr-dashboard-external

namespace: rook-ceph

labels:

app: rook-ceph-mgr

rook_cluster: rook-ceph

spec:

ports:

- name: dashboard

port: 7000

protocol: TCP

targetPort: 7000

selector:

app: rook-ceph-mgr

rook_cluster: rook-ceph

sessionAffinity: None

type: NodePort

dada@k8smaster:~/rook$ kubectl -n rook-ceph get service | grep Node

rook-ceph-mgr-dashboard-external NodePort 10.99.88.135 <none> 7000:31165/TCP 3m41s

Considérations

La gestion du système de fichiers que je vous propose n'est pas sans risque. Les volumes que vous allez créer doivent être configurés sérieusement. Les exemples que vous aller trouver par-ci par-là vous permettront d'avoir un stockage dans votre cluster k8s, certes, mais rendront sans doute vos volumes dépendants de vos pods. Si vous décidez de supprimer le pod pour lequel vous avec un PVC, le PV disparaîtra, et vos données avec.

Prenez le temps de bien réfléchir et de bien plus étudier la question que ce que je vous propose dans mes billets avant de vous lancer dans une installation en production.